“Pour Cerebras, 2026 sera une année charnière”, annonce son CEO, Andrew Feldman. Grâce à ce contrat avec OpenAI, l’entreprise va en effet pouvoir déployer ses puces d’inférence auprès de centaines de millions, voire des milliards d’utilisateurs. Le déploiement débutera début 2026 et devrait être pleinement opérationnel d’ici trois ans.

10 milliards de dollars. C’est ce que compte dépenser OpenAI pour acquérir 750 mégawatts de puissance de calcul auprès de Cerebras Systems sur trois ans, la mise en service étant prévue par tranches successives jusqu’en 2028. Pourquoi autant ? Pourquoi maintenant ? Parce qu’OpenAI fait face à une grave pénurie de puissance de calcul pour faire fonctionner ChatGPT et gérer ses 900 millions d’utilisateurs hebdomadaires.

Jusqu’alors, OpenAI se fournissait surtout en GPU Nvidia. Problème : ces derniers, bien que dominants sur le marché, sont rares, coûteux et constituent un point de blocage croissant pour les charges de travail d’inférence à mesure que la demande en applications d’intelligence artificielle croît.

Cerebras, l’alternative crédible face à Nvidia

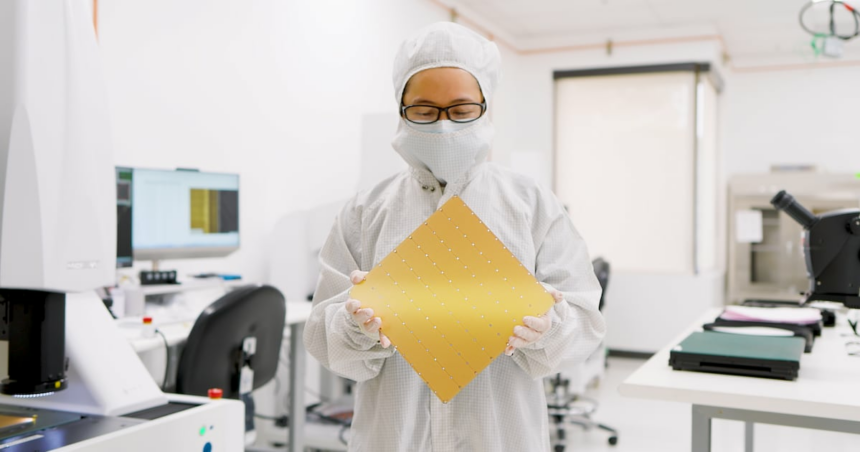

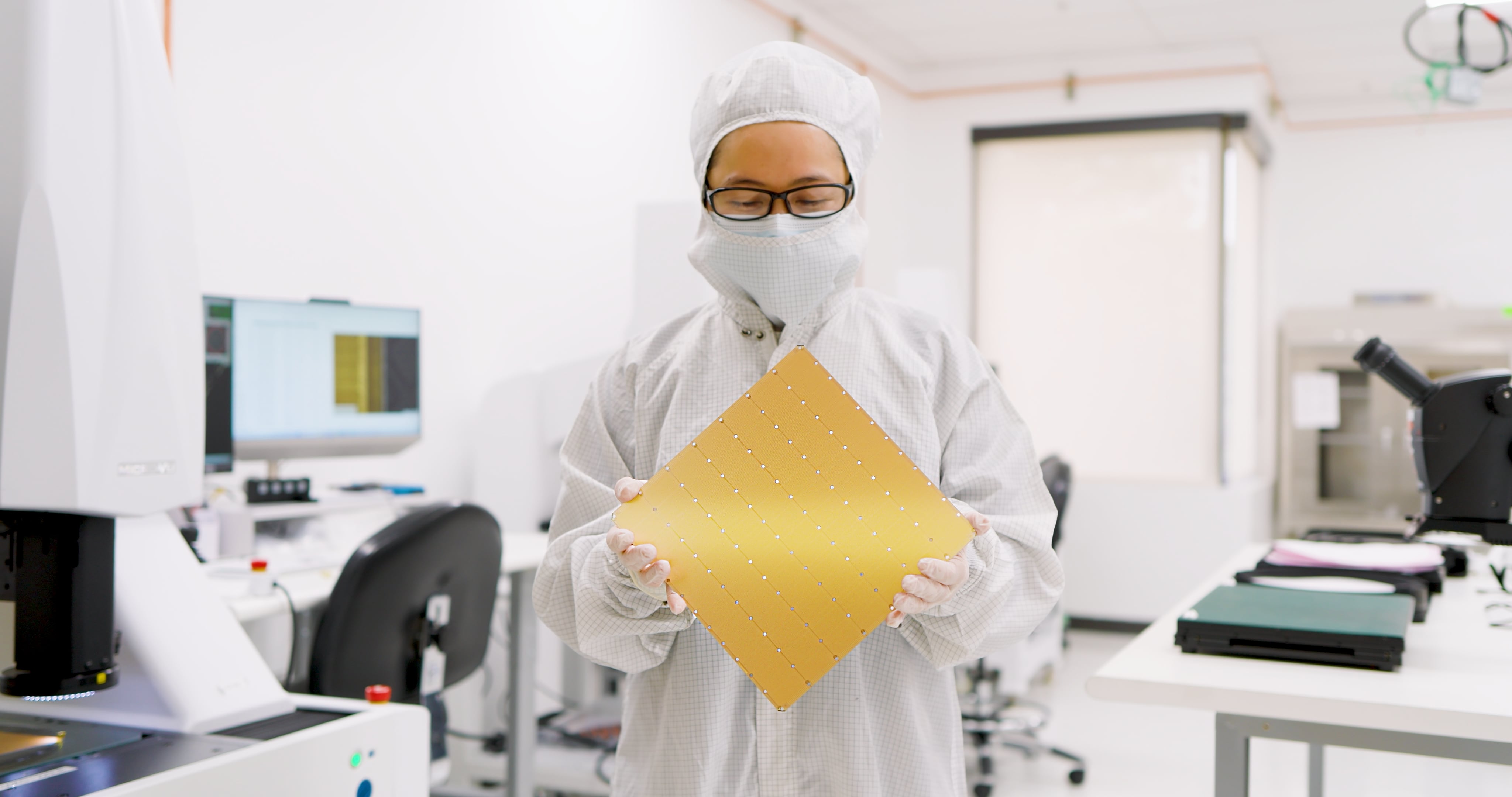

L’alternative s’appelle Cerebras. La start-up, basée à Sunnyvale (en Californie), a été cofondée en 2015 par cinq personnes et conçoit des puces selon une architecture fondamentalement différente de celle de Nvidia. Au lieu des GPU traditionnels qui transfèrent constamment des données (entraînant des ralentissements), Cerebras utilise des processeurs massifs à l’échelle de la plaquette qui consolident toutes les opérations sur une seule puce.

En résulte une rapidité, notamment pour les tâches d’inférence, qui fait la différence : les puces Cerebras peuvent traiter plus de 3 000 tokens par seconde, contre 650 pour Nvidia, soit quasi cinq fois plus vite. Pour certaines charges de travail, elles atteignent même 20 fois la vitesse des GPU Nvidia traditionnels, les plaçant au même niveau que des puces d’inférence spécialisées comme Groq.

Garder l’utilisateur le plus longtemps sur ses services

En intégrant ces puces dans l’ensemble de ses solutions de calcul, OpenAI espère ainsi rendre ses systèmes d’IA beaucoup plus réactifs. “Lorsqu’on pose une question complexe, qu’on génère du code, qu’on crée une image ou qu’on exécute un agent d’IA, une boucle se déroule en coulisses : la requête est envoyée, le modèle raisonne, puis il renvoie une réponse. Quand l’IA répond en temps réel, les utilisateurs en font davantage, restent plus longtemps et exécutent des charges de travail à plus forte valeur ajoutée”, commente le créateur de ChatGPT. Car oui, l’ambition est bel et bien de garder l’utilisateur le plus longtemps possible avec une expérience qui soit la plus fluide possible. Et la question de la latence est cruciale ici.

La fin d’un règne pour Nvidia ?

La volonté manifeste d’OpenAI de mettre fin à l’emprise de Nvidia sur son infrastructure IA est intéressante. Après avoir signé un accord de taille avec AMD en octobre dernier, l’entreprise de Sam Altman poursuit sa stratégie de multiplication de fournisseurs avec Cerebras. AMD doit pour sa part lui apporter 6 gigawatts avec un déploiement également échelonné : le premier déploiement de 1 gigawatt de GPU Instinct MI450 est prévu pour le second semestre 2026. Parallèlement, OpenAI planche sur un projet de développement de puces en interne avec l’aide de Broadcom.

Toutefois, diversifier ses fournisseurs ne signifie pas pour autant qu’OpenAI s’éloigne totalement de Nvidia. Dans un partenariat stratégique annoncé en septembre 2025, rappelons que les deux entreprises ont convenu de déployer au moins 10 gigawatts de systèmes Nvidiace qui correspondrait selon certaines estimations à environ 4 à 5 millions de GPU si on considère la puissance et la consommation des GPU de dernière génération dans ces systèmes.