L’intelligence artificielle est désormais la priorité n°1 d’AMD. Data centers, PCs, robots… Il veut être partout, et pouvoir regarder Nvidia dans les yeux sans sciller.

Si AMD a mis du temps à se mettre en ordre de marche sur le marché de l’intelligence artificielle, il est désormais bien décidé à s’y faire sa place. A sa conférence au CES 2026, sa dirigeante Lisa Su a déclaré que “l’IA est notre priorité numéro un chez AMD” avant de dérouler une vision couvrant à la fois les postes de travail, les centres de calcul et l’embarqué (comprendre : la robotique).

Les centres de calcul, le nerf de la guerre

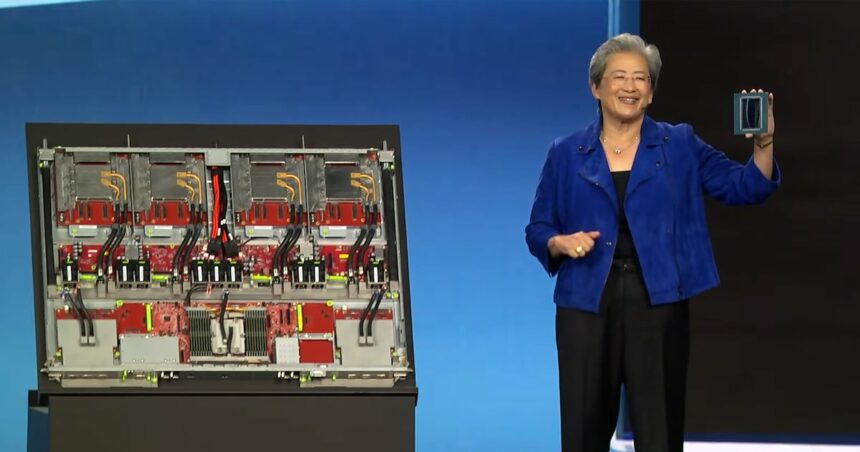

Après des débuts prometteurs en 2023 avec l’Instinct MIX300X, suivi d’une montée en puissance avec le MI350 en juin 2025AMD passe aux choses sérieuses avec la série MI400. Le flagship est le MI455X, un GPU pour l’IA capable de fournir 20 petaflops en précision FP8 et 40 PF en FP4, le tout pour une bande passante de 19,6 To/s.

Et pour pouvoir pleinement se mesurer aux prochains systèmes Vera Rubin de Nvidia, AMD a développé Helios, un rack basé sur le design “open hardware” de Meta qui est capable de fournir jusqu’à 3 exaflops avec 72 GPU et des CPU Epyc. La partie réseau est assurée par Pensando Vulcano, UALink et Ultra Ethernet, là encore des technologies ouvertes pour tenter de contrer Nvidia.

Cette solution “rack-scale” est accompagnée du MI440X, une solution serveur 8 GPU pour les data centers en propre, et du MI430X qui s’adresse aux systèmes “souverains”, c’est-à-dire financés par les gouvernements. Cela inclut Alice Recoque, le prochain supercalculateur français. AMD annonce aussi déjà des performances impressionnantes pour sa prochaine série MI500 : 1000 fois plus performante qu’un MIX300X. Elle s’appuiera sur l’architecture CDNA 6, avec de la mémoire HBM4E, et sera gravée en 2 nm. Elle est prévue pour 2027.

Testé et approuvé par OpenAI

Cela suffira-t-il à rogner les parts de marché de Nvidia ? A voir, mais AMD peut déjà se targuer d’un soutien de taille : OpenAI, dont le président et cofondateur Greg Brockman est intervenu pour vanter les progrès réalisés par AMD avec l’Instinct MI450. Il a réitéré qu’OpenAI a besoin de “milliards de GPU”, et ceux d’AMD rentrent clairement dans sa feuille de route.

Il a été suivi d’autres par d’autres interventions de dirigeants de laboratoires d’IA, dont Fei-Fei Li, fondatrice de World Labs. Il y a fort à parier qu’AMD va multiplier les contrats cette année, du moins si le boom des infrastructures IA se poursuit à la même vitesse.

ROCm monte en puissance

L’une des faiblesses de la “team red” face à la “team green” (Nvidia) est l’écosystème logiciel. CUDA sous-tend beaucoup d’applications IA aujourd’hui, ce qui rend de fait l’utilisation d’autres fournisseurs très difficile. AMD en est conscient et travaille dur sur ROCm, sa plateforme logicielle IA. Lisa Su a souligné une multiplication des performances IA par cinq au cours de l’année 2025, avec une compatibilité doublée sur ses CPU Ryzen et GPU Radeon, et un meilleur support sur Linux et Windows.

Pour simplifier la prise en main, AMD s’est même fendu d’un pack logiciel tout-en-un pour expérimenter avec de petits modèles en local sur son PC. Ces efforts semblent porter leurs fruits : le nombre de téléchargements de ROCm a été multiplié par dix l’année dernière, preuve de l’intérêt croissant de la communauté.

Un concurrent au DGX Spark

Nvidia nous avait intrigué avec le DGX Spark, un mini-PC pensé pour le développement IA, mais la commercialisation semble s’être faite au compte-gouttes, avec très peu de machines mises sur le marché. Malgré ça, AMD lance un concurrent baptisé Ryzen AI Halo. Il est conçu autour d’une nouvelle puce Ryzen AI Max+ et dispose de 128 Go de mémoire unifiée, permettant de faire tourner un modèle à 200 milliards de paramètres.

Il est compatible avec Linux et Windows, et peut même faire tourner des logiciels Autodesk (il dispose de 60 teraflops de puissance graphique). AMD promet aussi la compatibilité avec les principaux modèles d’IA du marché dès la sortie, dont GPT-OSS. Concernant la sortie justement, elle se fera au deuxième trimestre. De quoi séduire les développeurs ? Cela reste à voir. Le prix, notamment, n’a pas été spécifié.

AMD convoite le futur marché de la robotique humanoïde

Tout le monde s’accorde à le dire, la robotique est la prochaine grande vague d’innovation. AMD s’y positionne avec une nouvelle gamme de processeurs P100 qui cible notamment les automates industriels, l’automobile et les robots humanoïdes. Les premières puces de la série P100, destinées aux habitacles automobiles, intègreront entre 4 et 6 coeurs Zen 5, un GPU RDNA 3.5 et un NPU XDNA 2 capable de fournir jusqu’à 50 TOPS pour l’IA. Elles sont disponibles dès aujourd’hui.

Des modèles plus costauds, dotés de 8 à 12 coeurs et pensés pour l’industrie, auront de premiers échantillons disponibles d’ici fin mars. Enfin, des puces X100 pour la robotique avancée compteront jusqu’à 16 coeurs et sont attendues “au cours du premier semestre”. Là encore, un partenaire était présent à la conférence pour appuyer cette vision : Generative Bionics, une start-up italienne qui a dévoilé son robot humanoïde GENE1.0.