Trois versions de TranslateGemma, adaptées à un déploiement aussi bien sur mobile que dans le cloud, doivent répondre à un enjeu crucial : la traduction fait partie intégrante du paysage de l’intelligence artificielle et est une brique clé qu’il s’agit de maîtriser.

S’il y a bien un produit Google qui manque aujourd’hui cruellement d’efficacité, c’est bien Google Translate. Mais les choses pourraient bien changer avec l’arrivée de TranslateGemma, sa famille de modèles de traduction ouverts, construits sur Gemma 3 et disponibles en versions 4B, 12B et 27B. “Cette avancée marque une étape majeure pour la traduction open source”, assure le géant de la recherche qui cible ici pas moins de 55 langues.

Une qualité de traduction plus élevée avec un modèle plus compact

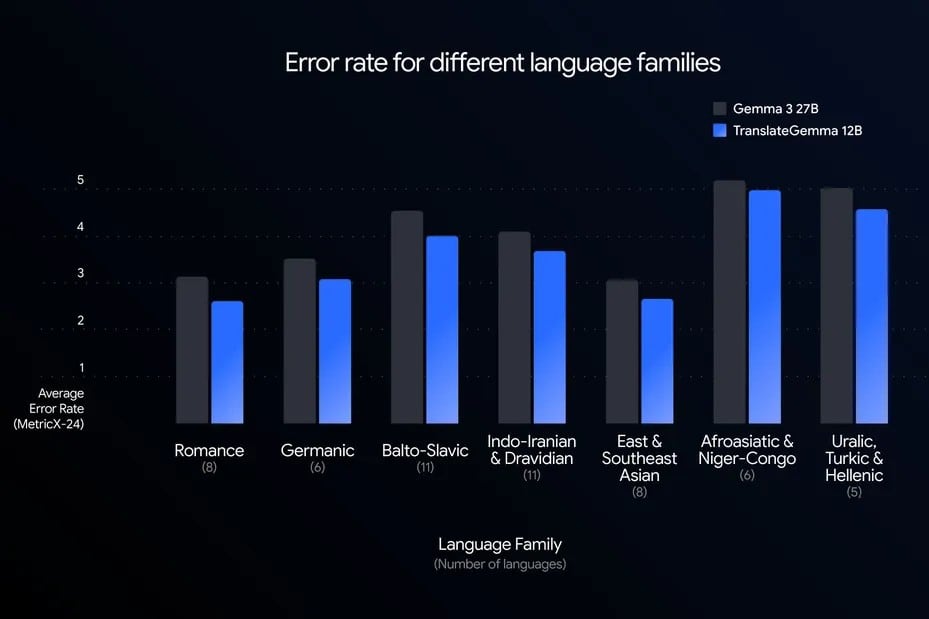

Ce qu’il faut noter ici, c’est l’efficacité des modèles développés. Google explique que, grâce à un processus d’entraînement spécialisé, le modèle TranslateGemma (version à 12 milliards de paramètres) surpasse son modèle de référence Gemma 3 27B, selon la métrique d’évaluation MetricX sur le benchmark WMT24++ (utilisé par la communauté de recherche pour évaluer la qualité des systèmes de traduction automatique) qui couvre 55 langues issues de nombreuses familles linguistiques, incluant des langues à ressources élevées, intermédiaires et faibles.

Pour y parvenir, l’équipe de Google en charge du développement de cette famille de modèles explique s’être appuyée sur un processus de fine-tuning en deux étapes où les modèles Gemini les plus puissants servent de base d’apprentissage : les comportements de traduction de haute qualité sont extraits puis compressés via deux phases d’entraînement pour les intégrer dans des modèles ouverts, plus petits, mais étonnamment performants.

Une base solide pour les développeurs

Au-delà de ce noyau de 55 langues, Google ajoute avoir “repoussé les limites en entraînant les modèles sur près de 500 paires de langues supplémentaires”. L’idée étant, à terme, de faire de TranslateGemma une base robuste pour des adaptations futures, offrant aux chercheurs un point de départ idéal pour finer-tuner leurs propres modèles sur des paires linguistiques spécifiques ou améliorer la qualité pour les langues peu dotées.

Avec cet ensemble de modèles, les développeurs peuvent en effet obtenir une qualité de traduction très élevée avec moins de la moitié des paramètres du modèle de référence. Cette percée en matière d’efficacité permet un débit plus élevé et une latence plus faible, sans compromettre la précision. Il est par ailleurs précisé dans le document de recherche que les modèles TranslateGemma conservent les fortes capacités multimodales de Gemma 3, avec des améliorations en traduction textuelle, notamment concernant du texte présent dans des images, et ce sans fine-tuning multimodal spécifique lors de l’entraînement de TranslateGemma.

Trois tailles pour trois environnements de déploiement différents

Il faut également souligner que Google a, une nouvelle fois, fait le choix de la diversité pour s’adresser au plus grand nombre. Le modèle à 4 milliards de paramètres est ainsi optimisé pour le mobile et l’edge computing, capable de rivaliser avec les performances du modèle de référence 12B, tandis que ce dernier est conçu pour fonctionner aisément sur des ordinateurs portables grand public, apportant une puissance de niveau recherche aux environnements de développement locaux.

Enfin, la version à 27 milliards de paramètres, dédiée à la fidélité maximale, est capable de tourner sur un seul GPU H100 ou sur TPU dans le cloud.

Le sujet de la traduction crucial dans le monde de l’IA

Il est intéressant de voir que le géant de Mountain View s’intéresse à nouveau au sujet de la traduction automatique. Lancé en avril 2006, Google Translate reposait à l’origine sur des méthodes statistiques, avant de passer au neural machine translation (NMT) à partir de 2016, ce qui a nettement amélioré la fluidité des traductions. Aujourd’hui, il prend en charge plus de 100 langues et Google a fait le choix de le laisser gratuit, instantané et intégré partout (web, mobile, Chrome, Android) pour accélérer son adoption.

Malgré cela, Google Translate est souvent jugé médiocre pour des usages exigeants. Il fonctionne très bien pour comprendre le sens général d’un texte simple, mais devient rapidement faible dès qu’il s’agit de nuances, de contexte, de ton ou de textes spécialisés (juridique, marketing, littérature). La démocratisation de l’IA a remis la traduction au premier plan parce qu’elle a fait exploser les échanges entre des personnes, des outils et des contenus qui ne partagent ni la même langue ni le même contexte culturel. Avant, la barrière linguistique limitait naturellement la circulation des idées : on consommait surtout des contenus produits dans sa langue ou traduits par des professionnels, donc en quantité réduite. Avec l’IA, la production de textes, de services et d’interfaces est devenue massive, instantanée et mondiale, ce qui rend la traduction non plus optionnelle mais structurelle.

L’IA a aussi transformé la traduction en brique d’infrastructure. Les agents, les copilotes, les chatbots, les logiciels métiers ou les plateformes collaboratives doivent fonctionner de manière fluide à l’échelle mondiale. Pour cela, ils doivent comprendre, générer et adapter des contenus dans des dizaines de langues en temps réel.

Par ailleurs, la généralisation des grands modèles de langage a mis en lumière les limites des traductions approximatives. Quand l’IA est utilisée pour coder, négocier, soigner, informer ou automatiser des décisions, une mauvaise traduction ne produit plus seulement une phrase maladroite, mais peut générer des erreurs fonctionnelles, juridiques ou culturelles. Cela a réhabilité l’idée que traduire, ce n’est pas seulement transposer des mots, mais préserver du sens, de l’intention et du contexte. Ce n’est d’ailleurs pas pour rien qu’OpenAI a également lancé cette semaine ChatGPT Translate, misant majoritairement sur la personnalisation pour attirer les utilisateurs. La guerre des traducteurs est lancée.