Un modèle fiable qui tient dans une poche de pantalon. C’est la promesse faite par Google avec FunctionGemma, un modèle qui allie puissance d’action (fonction calling) et compacité, permettant de créer des agents qui fonctionnent entièrement sur appareil, avec de bons résultats après fine-tuning dans le domaine visé.

Google fait, une nouvelle fois, état de ses prouesses en matière de développement et d’intelligence artificielle. Publiée il y a quelques jours, FunctionGemma est une version spécialisée du modèle Gemma 3 270M, optimisée pour l’appel de fonctions. La raison au lancement de cette version ? “Depuis le lancement du modèle Gemma 3 270M, la demande numéro un des développeurs a été l’intégration native du function calling. Nous avons écouté”, explique l’équipe qui a supervisé son développement.

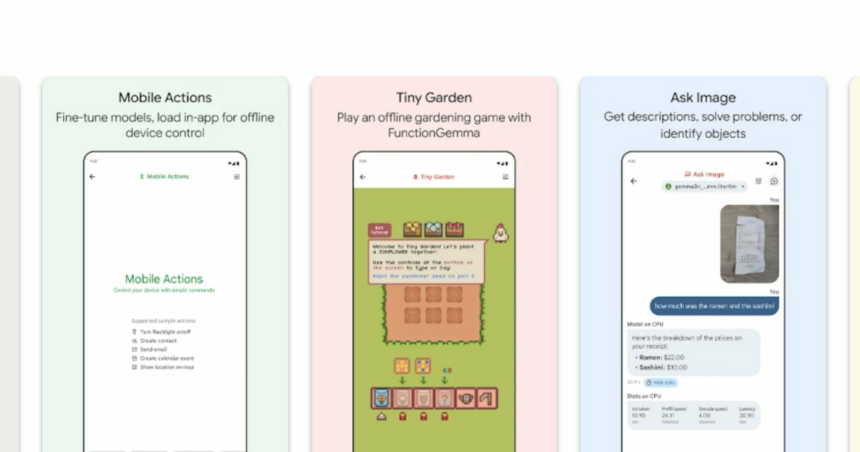

FunctionGemma a donc été conçu comme une base solide pour entraîner des agents personnalisés, rapides, privés et exécutés en local, capables de traduire le langage naturel en actions API exécutables.

“Faire le lien entre le langage naturel et l’exécution logicielle”

Pour présenter ce modèle, Google explique qu’il “fait le lien entre le langage naturel et l’exécution logicielle”. Plus concrètement, il est particulièrement adapté si une application repose sur un ensemble d’actions bien définies : il est prévu pour être fine-tuned sur un domaine ou un ensemble spécifique d’actions (par exemple commande domotique, planification, outils propres à une application).

Après fine-tuning sur des données spécifiques, le modèle devient beaucoup plus fiable et déterministe, ce qui est crucial pour des usages où il faut que l’agent comprenne et exécute précisément des commandes complexes.

Optimisé pour tourner sur un Samsung S25 Ultra

Google explique que le modèle est suffisamment compact et peut donc être exécuté localement sur des appareils à ressources limitées — comme des smartphones, ordinateurs ou des modules embarqués type Jetson Nano et DGX Spark de Nvidia — sans nécessité de connexion à un serveur externe, le tout avec une latence minimale.

Dans la fiche technique publiée sur Hugging Face, les équipes de Google expliquent avoir testé les performances des cas d’usage fine-tuned du modèle avec un Samsung S25 Ultra afin de mesurer la latence et l’empreinte mémoire en exécution locale. Les tests ont été faits uniquement sur le processeur (CPU) du S25 Ultra, en utilisant LiteRT, la bibliothèque de Google optimisée pour faire tourner des modèles d’IA sur appareils mobiles.

Les résultats montrent ainsi que le modèle peut répondre très rapidement à une commande ou conversation sans délai perceptible grâce à un débit de plus de 120 tokens/s pour le décodage. La latence initiale est relativement faible et l’expérience fluide puisque l’IA commence à produire une réponse en environ 0,3 secondes.

Côté mémoire, même si un smartphone n’a pas de GPU/NPU, le modèle tient dans moins d’un gigaoctet de RAM (594 MB exactement), ce qui confirme qu’il est réalisable à exécuter localement sans infrastructure serveur. Enfin, il ne sature pas la mémoire de stockage comme le prouvent les tests effectués.

Combiner FunctionGemma et modèles lourds

Si les utilisateurs finaux cherchent à construire des systèmes hybrides combinant un modèle léger embarqué et des modèles plus lourds pour les tâches complexes, FunctionGemma peut parfaitement faire partie de l’équation.

En clair, FunctionGemma peut fonctionner comme un agent totalement autonome pour des tâches privées et hors ligne, ou comme un contrôleur intelligent pour des systèmes connectés plus vastes. Dans ce rôle, il gère instantanément les commandes courantes et redirige les tâches plus complexes vers des modèles plus puissants comme Gemma 3 27B.

Un écosystème de déploiement

Google fournit aussi des outils et workflows complets pour entraîner et déployer ce modèle sur mobile ou dans l’edge, notamment via Hugging Face, LiteRT-LM, Vertex AI, vLLM, Llama.cpp, Ollama, etc. Ces outils aident à convertir et optimiser le modèle pour un fonctionnement rapide sur l’appareil et faciliter l’intégration dans des applications réelles.

Comme les autres modèles Gemma, FunctionGemma est publié en open weight et une licence autorisant un usage commercial responsable, ce qui permet de le personnaliser et de le déployer librement dans des projets et applications.